Le sujet de la censure et de la liberté d’expression sur Internet est régulièrement abordé en rapportant les protestations rageuses de uns et les discours sécuritaires des autres. De la censure morale : quand Facebook supprime L’Origine du Monde de Courbet, des photos des Femen, certaines formes de pornographie ou de voyeurisme. De la censure politique : quand certains régimes font supprimer les comptes Twitter d’opposants politiques ou s’en servent pour les arrêter et les jeter en prison. De la censure économique : quand Google annonce un possible changement d’algorithme qui classeraient les sites en jugeant automatiquement de la véracité de leur contenu (?!), au lieu de se fonder sur leur notoriété construite collectivement.

Non, parlons cette fois d’une autre réalité de la censure, celle qui cherche à faire disparaître, de la masse gargantuesque des données publiées, la barbarie à l’état pur, l’expression des bas-fonds de l’âme humaine, la lie de la lie, le pire du pire : viols, actes de torture, meurtres, etc.

Plus de 100 heures de vidéos sont publiées chaque minute sur YouTube, 4,75 milliards de contenus sont partagés sur Facebook chaque jour, 760 millions de vidéos et photos sont échangées quotidiennement sur Snapchat, etc. Et en face pour contrôler tout ça : des machines et des humains dont le rôle est de nous éviter de croiser, ici des actes innommables envers des enfants de deux ans, là un homme qui torture une jeune femme en la violant avec son crâne, là encore une décapitation qui n’en finit pas, ou ailleurs la maltraitance insoutenable d’un animal, le viol collectif d’une adolescente, filmé et publié comme un trophée par ses violeurs…

Cette face obscure des médias sociaux et des contenus autoproduits par les internautes, nous préférons la plupart du temps la mettre de côté, parce qu’elle est indicible, parce qu’elle reste marginale, parce qu’elle ne doit pas justifier la censure mentionnée plus haut, parce que cette violence abjecte fait partie de l’humanité, parce qu’elle existe en dehors d’Internet, parce que, parce que…

Oui, mais nous sommes quand même soulagés de ne pas y être confrontés au détour d’un clic innocent, de juste en entendre parler sans véritablement les regarder en face. Car la plupart du temps ces contenus sont éliminés avant de nous atteindre ou restent cantonnés à des sites confidentiels. Si ce niveau de violence inondait les réseaux sociaux, nous serions sans doute « vent debout » comme disent les médias, réclamant que les autorités, les entreprises ou la société civile agissent.

Ce sont parfois des algorithmes qui se chargent des basses œuvres, comme par exemple Photo DNA , ce programme de reconnaissance d’images de Microsoft, qui repère les contenus pédopornographiques et identifie les profils associés.

Mais le plus souvent ce sont des humains qui visionnent à longueur de journées les contenus litigieux. Ces hommes et ces femmes sont le lumpen prolétariat du numérique… Selon Wired, il y aurait plus de 100 000 personnes qui travailleraient ainsi dans l’ombre pour nous permettre de surfer sans risque. Certains sont aux Etats-Unis et en Europe, mais le gros de cette armée de censeurs se trouve aux Philippines, en Malaisie, au Maroc, en Inde, chez des sous-traitants de Facebook, YouTube, Snapchat, Twitter, Whisper, etc.

Jane Stevenson avait monté un service d’aide psychologique à l’attention des enquêteurs de la police britannique lors d’une opération de lutte contre la pédopornographie sur Internet dans les années 2000. Elle conseille aujourd’hui des plateformes de réseaux sociaux, dans l’accompagnement des modérateurs de contenu. Elle a relevé les mêmes types de souffrances et de traumatismes que ceux rencontrés par les policiers. Mais les entreprises high tech sont loin d’avoir des procédures de recrutement et d’accompagnement comparables à celles des forces de l’ordre. Une psychologue philippine compare même les traumatismes de ces modérateurs à des troubles de stress post-traumatique . « Dès les premières images, vous ne serez plus jamais le même, cela vous change à jamais », précise Jane Stevenson.

Il y a près de trois ans, le témoignage d’un ancien employé de Google provoquait une vague d’indignation, vite retombée. Il travaillait à la vérification des contenus signalés sur YouTube, Picasa, Google Search… et visionnait environ 15 000 contenus par jour, avec une priorité sur la pédopornographie. Au bout de quelques mois, il a rencontré de sérieux problèmes psychologiques (dépression, altération du jugement). Google lui a alors payé une séance chez le psy, puis a mis un terme à son contrat. Selon lui, de nombreux jeunes diplômés, dans l’espoir d’une carrière au sein de la firme de Mountain View, ont accepté un contrat similaire et ont finit psychologiquement broyés et sans emploi.

Que faire de ces contenus odieux ? Faut-il les censurer et si oui comment ? Certains d’entre eux sont des dénonciations malheureusement nécessaires. Ainsi la vidéo postée par Wael Abbas, bloggeur égyptien : elle dévoile deux policiers en train de sodomiser un chauffeur de bus avec une matraque ; or cette vidéo a entraîné des poursuites inédites en Egypte contre les policiers. Trier ce type d’horreurs s’avère donc nécessaire, non seulement pour prévenir, enquêter et s’il le faut punir, mais pour éviter d’exposer intensivement des milliers de personnes connectées, et en particulier des enfants, à des images traumatisantes. Sauf que ce tri de l’immonde, des êtres humains doivent bien s’en charger. Car les algorithmes sont trop faillibles en cette matière très délicate ne permettant pas l’à peu près.

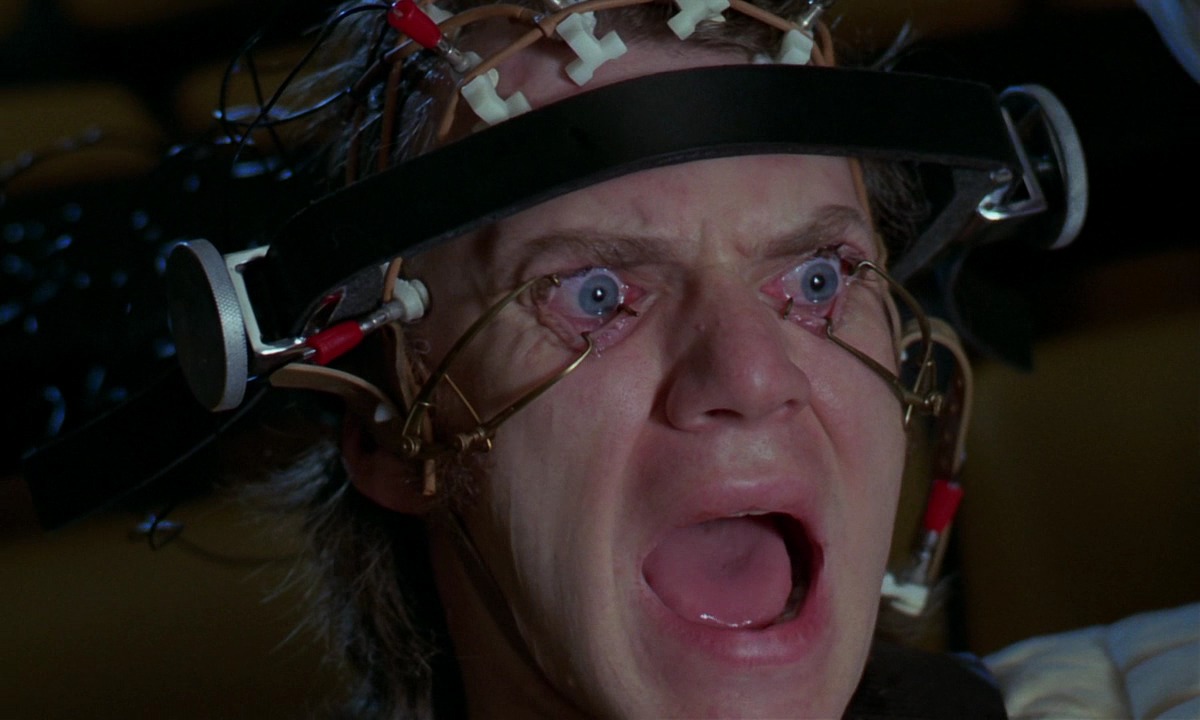

Mais pourquoi faudrait-il que cette mission ne soit réalisée que par les individus les plus pauvres et dans les régions les plus défavorisées de la planète, le plus loin possible de l’impeccable cœur de notre civilisation occidentale ? Pourquoi ce travail au profit des riches plateformes de la Silicon Valley et d’ailleurs ne serait-il pas effectué de façon tournante par les acteurs de ces sociétés-là ? Et quid de l’accompagnement psychologique ? Il ne s’agit pas d’un programme expérimental façon Orange Mécanique afin de dégoûter les criminels de la violence. Ces sociétés devraient soutenir ces modérateurs où qu’ils soient de façon sérieuse et pérenne, en partenariat avec des organismes publics et civils, car ce problème nous engage tous, nous autres qui profitons de l’infinie richesse du Net. L’enjeu est autant de prévenir que d’avoir conscience de cette face honteuse du monde numérique. Il est éthique. Il est civique. Il est politique.